오늘은 최종적으로 스태킹앙상블 회귀예측 프로젝트를 마무리하는 날이다.

최근까지의 진행사항을 정리해보겠다.

저번까지 베이스모델을 다음 3개로 고정시켜놓고,

: LGBM,XGB,CatBoost

메타모델로 하이퍼파라미터 튜닝된 CatBoost와 KNN을 사용하여 결과를 비교해보았다.

< 지난 포스팅 >

https://jayindustry.tistory.com/45

[머신러닝/딥러닝] 회귀예측 13 - 스태킹앙상블2, KNN 하이퍼파라미터 튜닝

오늘은 지난시간에 고민했던 부분들을 모두 직접 시도해보았다. 저번포스팅에서는 하이퍼파라미터 튜닝을 한 3개의 모델을 가지고 LGBM을 최종 메타모델로하여 스태킹 앙상블을 진행하였다. 하

jayindustry.tistory.com

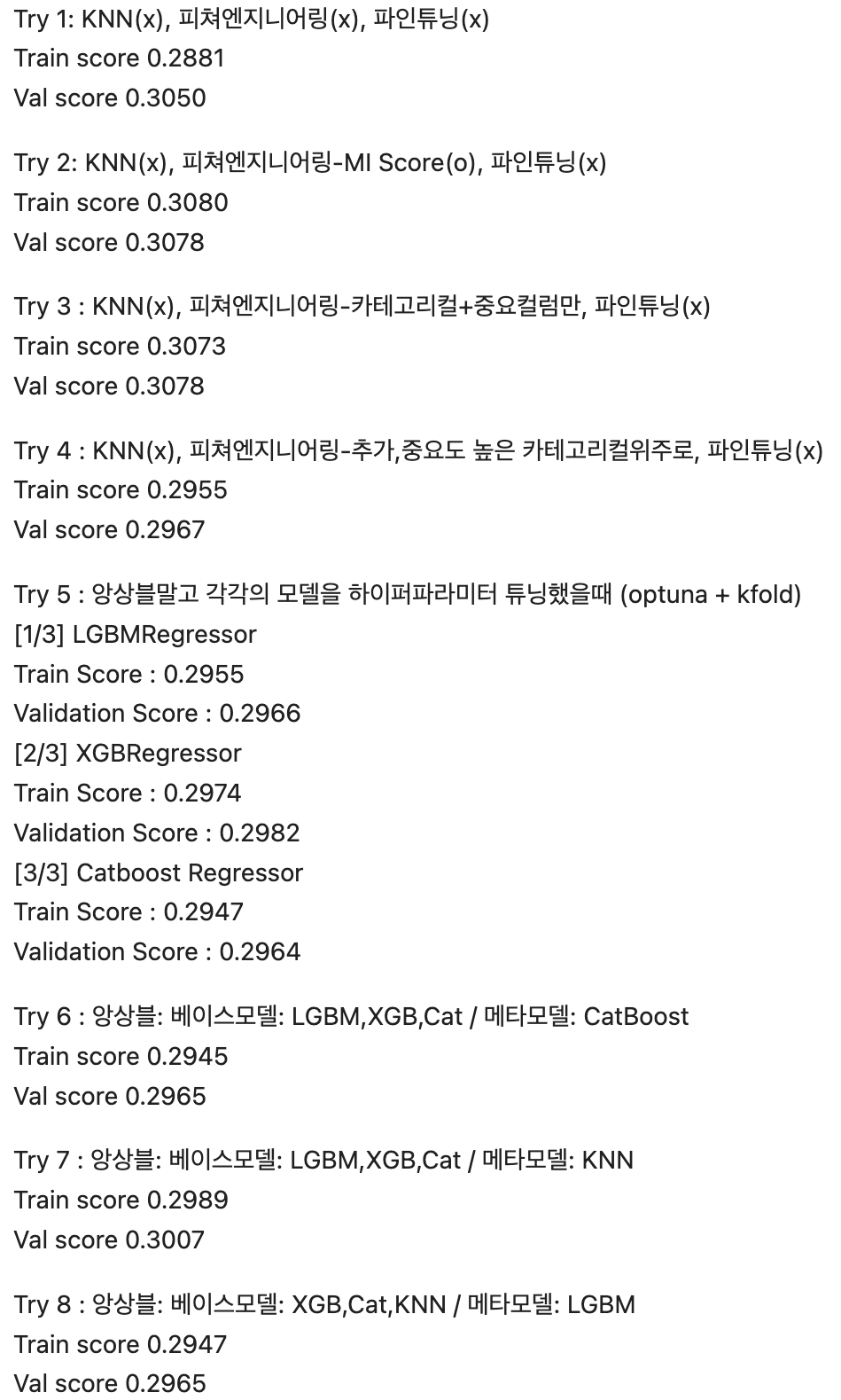

결과만 가져오면 다음과 같다.

CatBoost

KNN

그래서 오늘은 마지막으로 베이스모델과 메타모델을 바꿔서 진행해보았다..!

[ 개요 ]

Try 7 스태킹 앙상블

- 베이스모델: XGB,Cat,KNN

- 메타모델: LGBM

베이스모델 3개를 각각 옵튜나 + k fold로 하이퍼파라미터 튜닝 및 학습 후,

스태킹앙상블 기법으로 메타모델을 LGBM으로 정하여 최종 예측을 진행한다.

[ 내용 ]

총 4개모델의 하이퍼파라미터 튜닝코드는 이번 프로젝트 "[회귀예측]" 시리즈에 모두 포스팅되어 있으니 참고하면 좋을것이다.

kaggle노트북을 매번 edit할때마다 런하면 너무 오래걸리므로,

이전에 했던 하이퍼파라미터 튜닝에서 나온 베스트값들을 변수로 저장해놓았다.

그리고 각각을 학습시킨 후,

아래와 같이 검증해보았다.

베이스모델은 3개로 선정하였으나,

위 코드에서는 4개 모두 하이퍼파라미터 튜닝하고 검증한 것이다.

마지막 메타모델에서 사용될 스태킹 데이터셋에서는 여기서의 LGBM예측값을 뺄 예정이니 상관없다.

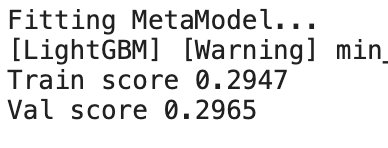

아래는 각각의 모델들을 따로 하이퍼파라미터 튜닝했을 때의 결과이다.

이들의 예측결과값들을 각각 csv파일로 저장하여 로딩한 후,

병합하여 최종모델이 학습및검증데이터로 사용할 수 있도록 전처리한다.

이제 이 데이터셋을 가지고 LGBM 하이퍼파라미터 튜닝 후,

베스트 params로 학습시켜 최종결과를 비교한다.

[ 결과 ]

[ 최종 결과 비교]

'AI > ML DL' 카테고리의 다른 글

| 맥북 딥러닝 GPU사용하기 (0) | 2024.01.18 |

|---|---|

| [머신러닝/딥러닝] 회귀예측 16 (최종제출) - Cat,XGB,LGBM,스태킹앙상블 (0) | 2023.10.10 |

| [머신러닝/딥러닝] 회귀예측14 - VIF, 다중공선성, EDA (1) | 2023.10.03 |

| [머신러닝/딥러닝] 회귀예측 13 - 스태킹앙상블2, KNN 하이퍼파라미터 튜닝 (2) | 2023.10.02 |

| [머신러닝/딥러닝] 회귀예측 12 - 스태킹앙상블 (0) | 2023.10.01 |